tg-me.com/nlp_stuff/327

Last Update:

معرفی Toolformer

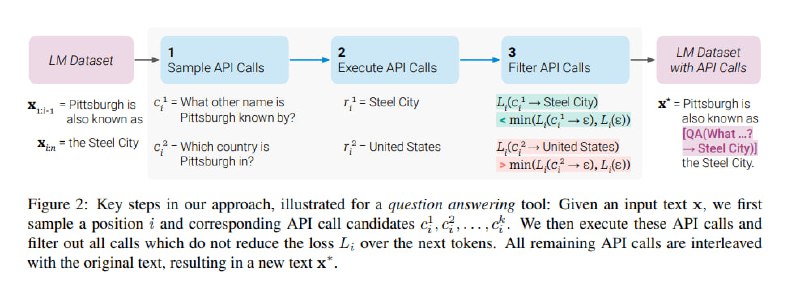

مدلهای زبانی، در حل وظایف جدید با تنها چند مثال یا دستورالعمل متنی تواناییهای قابل توجهی دارند، به ویژه در مقیاس بزرگ. در عین حال، برای عملکردهای پایهای مثل محاسبات یا جستجوی factها دچار مشکل هستند، جایی که مدلهای سادهتر و کوچکتر بسیار عالی عمل میکنند. این مقاله با معرفی Toolformer، نشون میده که مدلهای زبانی چطوری میتونند خودشون رو با استفاده از APIهای ساده، آموزش بدن تا بهترین راهکار رو داشته باشند. مدل Toolformer، آموزش میبینه که تصمیم بگیره کدام API رو فراخوانی کنه، چه زمانی اونها رو فراخوانی کنه، چه آرگومانهایی رو منتقل کنه و چطوری به بهترین شکل از ترکیب نتایج برای پیشبینی توکن بعدی استفاده کنه.

این APIهای گنجانده شده در Toolformer شامل ماشین حساب، سیستم پرسش و پاسخ، موتور جستجو، سیستم ترجمه و یک تقویمه. آموزش این مدل به صورت خودبخودی و خودآموزه، که تنها به چند تا نمونه برای هر API نیاز داره. یعنی با استفاده از تعداد انگشت شماری نمونههای نوشته شده توسط انسان از فراخوانی یک API، به مدل این امکان داده میشه که برای یک مجموعه دادهی زبانی بزرگ، کاندیدهای فرخوانی API رو مرتبط با محتوای متن ایجاد کند (in-context learning). سپس با استفاده از یک تابع self-supervised loss مشخص میشه کدام فراخوانی APIها واقعا به مدل برای پیشبینی توکن بعدی کمک میکنه. در نهایت مدل روی فراخوانهای API ای که مفیدند finetune میشه.

مدل Toolformer، عملکرد zero-shot رو برای مدل GPT-J با 6.7B پارامتر به طور قابل توجهی بهبود می بخشه و باعث میشه حتی از مدل بسیار بزرگتر GPT-3 در طیف وسیعی از وظایف مختلف پاییندستی (یا همان downstream tasks) بهتر عمل کنه، بدون اینکه تواناهایی مدل سازی زبان اصلی را ازدست بده.

لینک مقاله:

https://arxiv.org/abs/2302.04761

پ.ن. این پست را خانم وحیدی درست کردند و به کانال فرستادند. شما هم اگر پست خوبی دارید بگید تا به اسم و با لینک به لینکداین خودتون منتشر کنیم.

#read

#paper

@nlp_stuff

BY NLP stuff

Share with your friend now:

tg-me.com/nlp_stuff/327